*WAN-Alpha를 위한 논문 리뷰 글입니다! 궁금하신 점은 댓글로 남겨주세요!

WAN-Alpha paper: https://arxiv.org/pdf/2509.24979

WAN-Alpha github: Wan-Alpha

Wan-Alpha

Wan-Alpha Video Generation with Stable Transparency via Shiftable RGB-A Distribution Learner 1Haotian Dong, 2Wenjing Wang, 2Chen Li, 2Jing Lyu, 1Di Lin 1Tianjin University, 2Individual Researcher

donghaotian123.github.io

Contents

2. Background Knowledge: TransPixar

Simple Introduction

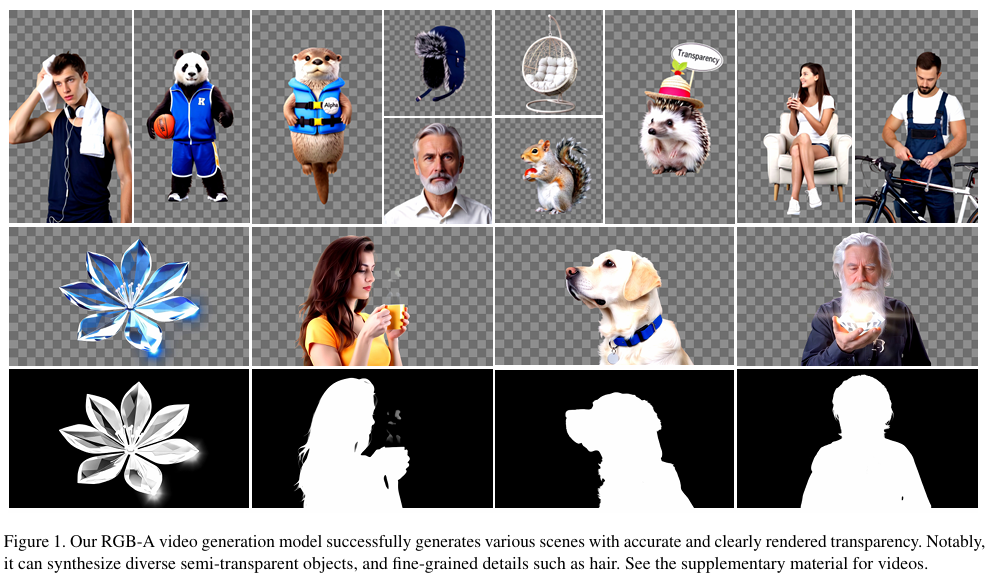

최근 Video Generation 연구가 활발해지면서, WAN과 같은 open-source diffusion model이 정말 각광받고 있다.

하지만, 기존의 video generation 연구는 RGB channels를 가지고 있어 실제 산업에서의 용이성이 살짝은 부족하다고 할 수 있다.

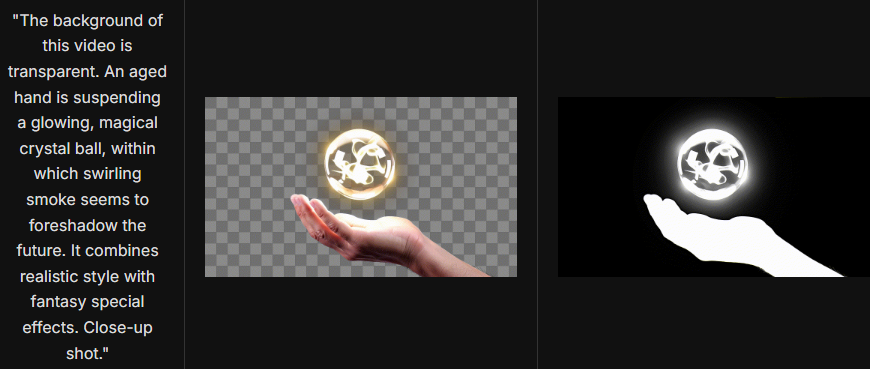

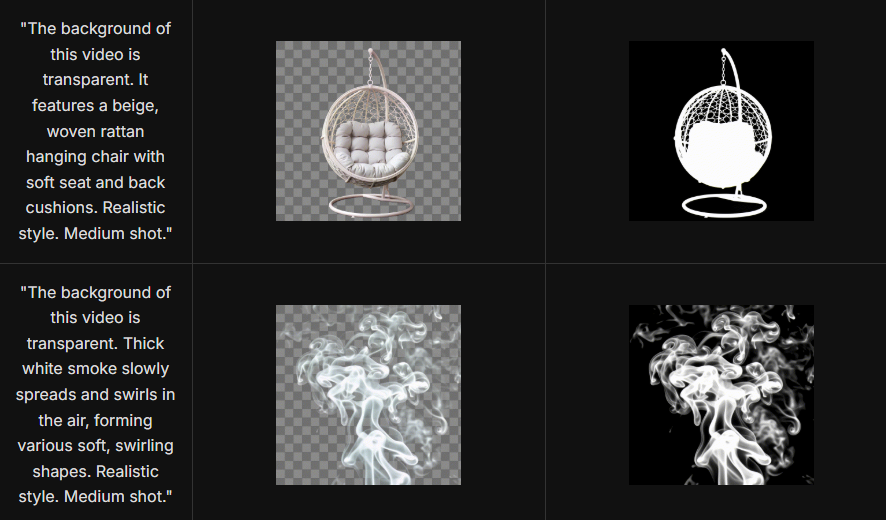

오늘 소개할 WAN-Alpha 논문은, text-to-video이지만, video가 RGBA format으로 되어있는 연구이다. (이해하기 쉽게 그린스크린 영상소스를 생각하면 됨!)

해당 연구는 매우 novelty가 있다고 볼 수 있는데,

- 우선 text로 쉽게 RGBA video를 추출할 수 있으며

- 동물의 털, 유리잔, 불꽃 등과 같이 반투명성을 띄는 object에 대한 alpha mask를 얻을 수 있다는 점이다!

(예를 들어, 유리잔의 alpha mask는 0.3 정도)

해당 연구는 기존의 RGB video generation model을 기반으로 RGBA video generation model를 제작하였는데, 어떻게 훈련을 시킨 것인지 같이 살펴보자!

Background Knowledge: TransPixar

TransPixar 논문 리뷰: https://kyujinpy.tistory.com/168

[TransPixar 논문 리뷰] - Advancing Text-to-Video Generation with Transparency

*TransPixar를 위한 논문 리뷰 글입니다! 궁금하신 점은 댓글로 남겨주세요! TransPixar paper: [2501.03006] TransPixar: Advancing Text-to-Video Generation with Transparency TransPixar: Advancing Text-to-Video Generation with Transpar

kyujinpy.tistory.com

- Adobe에서 작년에 공개한 RGBA video generation network인데, 해당 연구와 어떻게 다른지 차별점을 보는 것도 되게 좋은 시각이 될 수 있을 것 같다.

Method

RGBA-VAE Training

우선 해당 논문에서는, VAE부터 새롭게 훈련을 시켰다.

일단 WAN2.1 모델의 VAE를 가져와서 fine-tuning을 시켰다고 간단하게 생각할 수 있다.

일단 모델의 구조를 살펴보기전에, 그림의 왼쪽에 있는 hard-rendered와 soft-rendered 부분을 살펴보겠다.

- Hard-rendered는, [0,1] 사이의 alpha mask 값에서 0인 부분을 제외하고 나머지에 해당하는 RGB foreground를 나타낸 것이고,

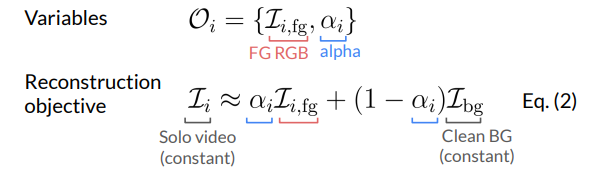

- Soft-rendered는, background color와 foreground을 alpha blending 수식을 통해 계산해서 RGB foreground를 나타낸 것이다. (위의 수식 참고; background color는 RGB + CMYK + White를 활용한다.)

즉 쉽게 말해서, hard는 alpha 부분이 전혀 고려가 안된 RGB이고, soft는 alpha blending을 수행한 RGB이다.

다시 위의 모델 figure로 올라가서, RGBA video를 hard-rendered와 alpha mask로 구분하고 이를 각각의 VAE encoder에 넣어서 latent vector를 추출한다.

그리고 feature merge block (M)을 통해서 합성된 latent vector를 만들도록 네트워크를 훈련하게 된다.

Feature merge block에서 나온 vector에 noise를 더해서 diffusion 모델에 넣어주고, 불투명한 부분에 대한 noise에 대해서만 loss function을 계산한다.

- 이는, 기존에 diffusion이 가지고 있는 불투명한 object 부분에 대한 noise 예측 prior를 모델이 학습할 수 있도록 guidance

마지막으로 합성된 latent vector에 대한 reconstruction을 decoder를 통해서 할 때, RGB decoder / Alpha decoder를 구분하여 lora로 각각을 fine-tuning 한다.

- 위와 같은 과정을 통해, RGBA video에 대한 VAE reconstruction을 훈련한다!

RGBA video에 대한 loss functions은 되게 많다!

일단 alpha mask video / soft-rendered video / hard-rendered video 3가지 type에 아래의 loss functions이 모두 적용되어 모델 학습이 이루어진다.

- Perceptual loss + Edge gradient loss (using sobel operator) + L1

Diffusion Training

Diffusion model의 경우, 기존과 거의 동일하게 진행이 된다!

Feature merge block에서 나온 latent vector로 diffusion model을 fine-tuning하기 위해 DoRA를 활용한다.

DoRA는 LoRA의 한계점을 지적해서 나온 방법론인데, 사실상 lora와 하는 역할 자체는 똑같다고 보면 된다.

간단하게 설명하면, DoRA가 조금 더 domain adaptation이 뛰어난 성능을 보여서, RGB에서 RGBA로 domain이 옮겨질 때 학습이 더 잘 되도록 DoRA를 활용한 것 같다.

*Wan-alpha v2.0 버전이 나오면서, noise sampling에 대한 새로운 방법도 제안했는데 관심있으신 분은 한번 논문을 찾아보세요!

Result

- 더 많은 결과는, project page를 참고하면 있습니다!

- 2026.01.18 Kyujinpy 작성.

*Happy New Year! 이번년도 대학원도 힘내볼게요!