*FlowDirector를 위한 논문 리뷰 글입니다! 궁금하신 점은 댓글로 남겨주세요!

FlowDirector paper: https://arxiv.org/abs/2506.05046

FlowDirector: Training-Free Flow Steering for Precise Text-to-Video Editing

Text-driven video editing aims to modify video content according to natural language instructions. While recent training-free approaches have made progress by leveraging pre-trained diffusion models, they typically rely on inversion-based techniques that m

arxiv.org

FlowDirector github: FlowDirector: Training-Free Flow Steering for Precise Text-to-Video Editing

SOCIAL MEDIA TITLE TAG

SOCIAL MEDIA DESCRIPTION TAG TAG

flowdirector-edit.github.io

Contents

2. Background Knowledge: FlowEdit

Simple Introduction

Training-free 방법으로 image 및 video editing하는 논문들이 되게 많이 나오고 있다!

하지만 inversion-free로 image editing하는 방법은 있어도 video-editing하는 방법은 없었다!

가장 대표적인 이유로는, DDIM 기반으로 작동되는 inversion-free 방법이 비디오 생성 모델에 전혀 working하지 않았다는 점이다.

(예를 들면, InfEdit 방법으로 CogVideoX에 적용했을 때 아예 작동되지 않음; 저의 대학원 연구에서 확인함.)

하지만 최근에 rectified flow가 엄청나게 유행을 타면서, rectified flow 기반 inversion-free image editing 방법인 FlowEdit이 등장했다.

(저의 대학원 연구에서) FlowEdit을 flow 기반 비디오 생성 모델인 WAN2.1과 결합하였을 때 매우 working이 잘 된다는 것을 확인했고, 아마도 FlowEdit과 더불어서 조금 더 기술적인 테크닉을 넣어서 video editing method를 완성한 것 같다.

FlowEdit + Attention masking (editing할 지역 선택) 방법을 활용하였는데, 자세한 내용은 아래에서 살펴보자!

Background Knowledge: FlowEdit

FlowEdit 논문 리뷰:https://kyujinpy.tistory.com/175

[FlowEdit논문 리뷰] - Inversion-Free Text-Based Editing Using Pre-Trained Flow Models

*FlowEdit를 위한 논문 리뷰 글입니다! 궁금하신 점은 댓글로 남겨주세요! FlowEdit paper: https://arxiv.org/abs/2412.08629 FlowEdit: Inversion-Free Text-Based Editing Using Pre-Trained Flow ModelsEditing real images using a pre-trained

kyujinpy.tistory.com

*FlowEdit의 inversion-free 방법을 기반으로 video editing을 진행합니다!

Method

일단 기본적으로 source video가 input이 된다!

그리고 flowedit 방법을 활용하여, source video와 target video간의 차이를 서서히 더해가면서 video editing을 수행하게 된다.

핵심이 되는 부분은 2가지가 있는데, attention masking과 DAG (differential averaging guidance)이다.

Attention masking은 매우 간단한 메커니즘이다.

- 여기서, attention map은 query와 key를 곱한 matrix를 얘기한다. (+softmax까지 적용)

- 각 prompt에서 object text에 해당하는 attention부분을 가져와서, latent video shape과 일치하도록 reshape을 수행한다.

- 그리고 normalization을 수행하여, attention map이 0과 1사이로 표현되도록 만든다.

- 논문에서 threshold 값은 attention map의 global average value를 사용한다.

- 논문에서 18번째 DiT block에서 attention map을 추출한다.

DAG는 말이 엄청 어려운데, 쉽게 얘기하면

t step에서 N번 velocity를 계산하고, 해당 velocity를 averaging해서 이용하겠다는 얘기이다.

(1번만 수행하면 inference할 때마다 약간씩 다른 결과가 나오고 퀄리티가 낮아진다)

논문에서는 L_HQ, L_BL 개수로 구분하여, high-quality velocity와 baseline quality velocity를 구분해서 L번씩 계산하고

각 velocity마다 평균을 계산한 다음, 적절하게 더해주어서 V_DAG를 만든다. (equation 7처럼)

논문에서는 (L_HQ, L_BL) = (4, 2)로 설정하여, 실제로 해당 모델은 1 step당 총 6번의 velocity를 계산하게 된다.

(=> 따라서, 시간이 좀 걸리게 됨.)

*(개인적인 의견으로) attention masking 말고, inversion-free editing 방법이나 DAG와 관련된 기술은 flowedit에서 다 사용되었던 테크닉인 것 같은데.. flowdirector 논문이 어디 학회 붙을지 매우 궁금하다

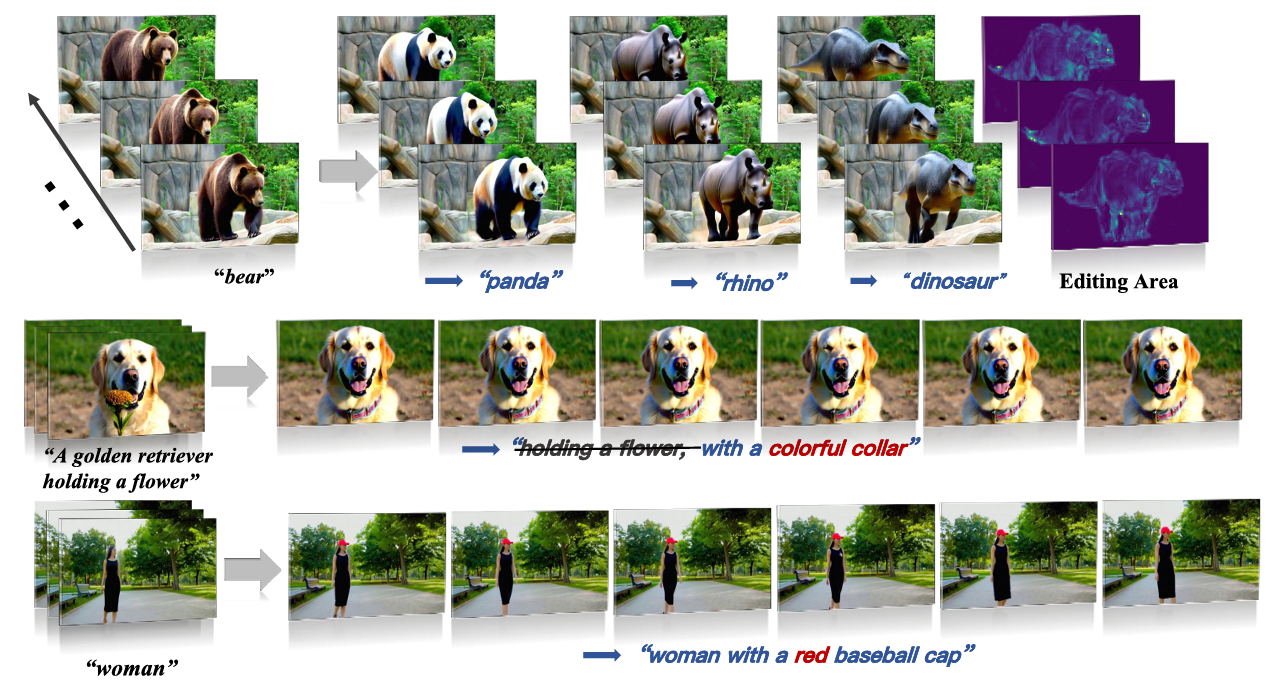

Result

- Attention masking과 DAG 유무에 따른 성능 비교!

- quantiative 비교; 다른 training-free 방법과 비교해서 성능이 좋다

- 2025.08.15 Kyujinpy 작성. (오늘 논문리뷰 2개나 했다~)