🥮Github🥮: https://github.com/Marker-Inc-Korea/KO-Platypus

GitHub - Marker-Inc-Korea/KO-Platypus: [KO-Platypus] Korean-Open-Platypus 번역 데이터셋을 활용한fine-tuning Platypus

[KO-Platypus] Korean-Open-Platypus 번역 데이터셋을 활용한fine-tuning Platypus - GitHub - Marker-Inc-Korea/KO-Platypus: [KO-Platypus] Korean-Open-Platypus 번역 데이터셋을 활용한fine-tuning Platypus

github.com

🥮Huggingface🥮: https://huggingface.co/kyujinpy/KO-Platypus2-7B-ex

kyujinpy/KO-Platypus2-13B · Hugging Face

This model can be loaded on the Inference API on-demand.

huggingface.co

🥮Dataset🥮: https://huggingface.co/datasets/kyujinpy/KOpen-platypus

kyujinpy/KOpen-platypus · Datasets at Hugging Face

"팔면체는 회전으로 구분할 수 없으므로 일반성을 잃지 않고 면을 빨간색으로 고정합니다. [asy] size(8cm); defaultpen(0.5); import three; import math; currentprojection=orthographic(2,0.2,1); triple A=(0,0,1); triple B=(sqrt(

huggingface.co

KO-Platy🥮: 한국어 번역 Open-platypus를 활용하여 llama-2-ko를 fine-tuning한 KO-platypus model

- 🥮Github(Ko-Platy)🥮:https://github.com/Marker-Inc-Korea/KO-Platypus

- 🥮Blog🥮:https://kyujinpy.tistory.com/101

- 🥮Dataset🥮:https://huggingface.co/datasets/kyujinpy/KOpen-platypus

안녕하세요!

(주)마커와 (주)미디어그룹사람과숲의 오픈소스 LLM 연구 컨소시엄의 지원을 받아서 연구하고 있는 Kyujin입니다😄

KOpen-Platypus 데이터셋과 colab의 A100 GPU를 활용하여서 llama-2-ko를 fine-tuning하고, 기존의 llama-2-ko의 backbone에 가중치를 merge시키면서 🥮KO-Platypus2-7B-EX🥮를 만들었습니다!

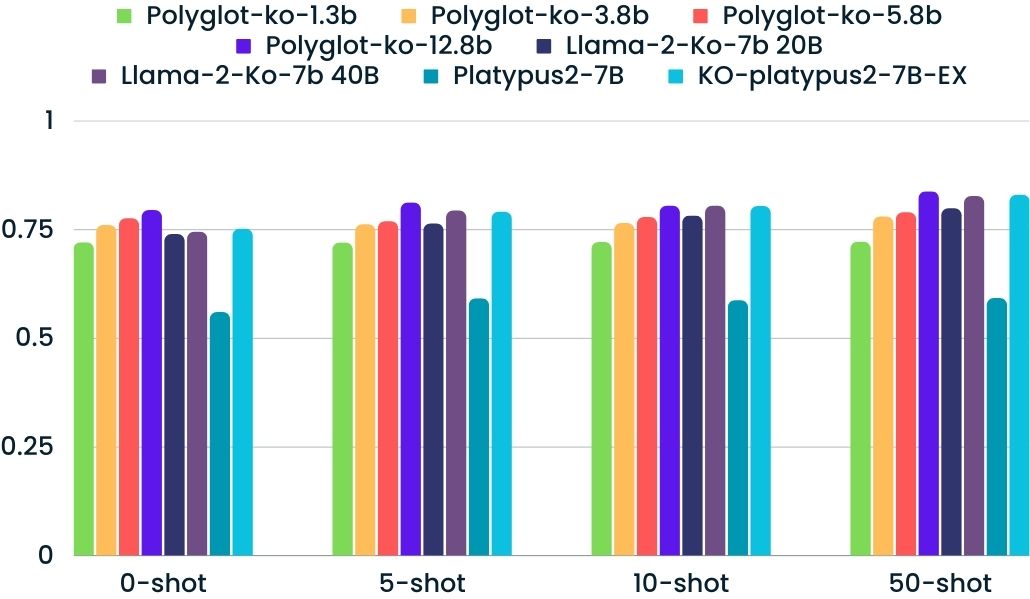

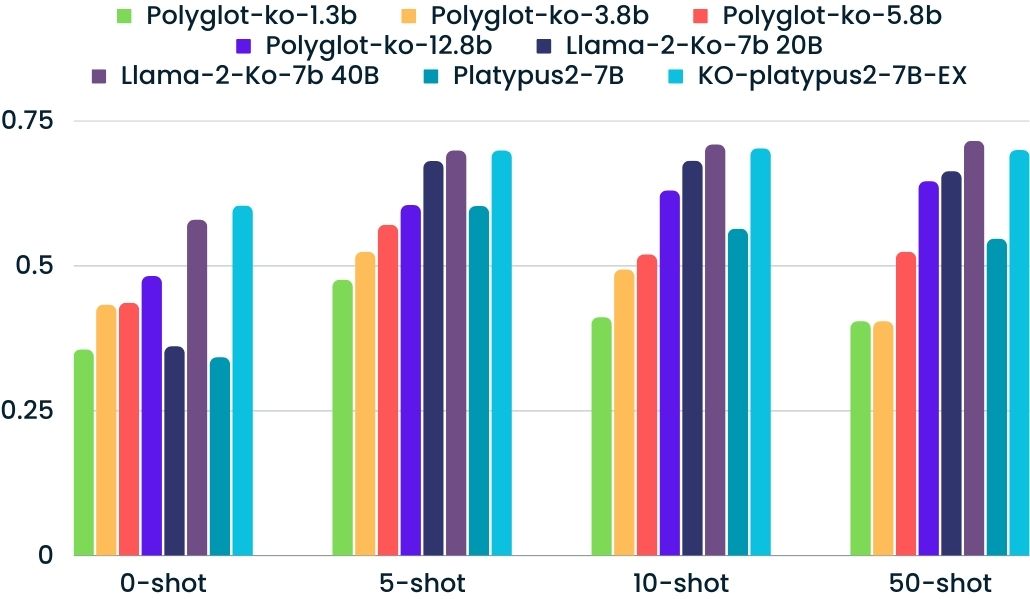

성능적인 측면에서 🥮KO-Platypus2-7B-EX을 보면🥮 zero-shot 부분에서 llama-2-ko보다 높은 성능을 보였고, boolQ에서는 Polyglot-ko보다 높은 성능을 보였습니다.

모델에 관한 자세한 정보는 Github와 Huggingface를 통해서 확인해보실 수 있습니다! 긴 글 읽어주셔서 감사합니다!!😄

2023.09.06 Kyujinpy 작성.

'AI > LLM project' 카테고리의 다른 글

| [Poly-platypus-ko] - Polyglot-ko + Ko-Platypus (0) | 2023.10.02 |

|---|---|

| [KoT-platypus2] - CoT + KO-platypus2 (0) | 2023.09.30 |

| [CoT-llama2] - Chain-of-thought 방식을 활용하여 llama2-ko를 fine-tuning (0) | 2023.09.28 |

| [DeepL] python을 이용한 한국어 번역 자동화 코드 (Not Pro and API. Using selenium) (0) | 2023.07.27 |

| [KoChatGPT 코드 리뷰] - KoChatGPT: ChatGPT fine tuning with korean dataset (0) | 2023.05.18 |